Na de schandalen rond Diederik Stapel en Dirk Smeesters is nu weer een hoogleraar sociale psychologie ernstig in de problemen gekomen. Het Landelijk Orgaan Wetenschappelijke Integriteit oordeelt dat professor Jens Förster, verbonden aan de Universiteit van Amsterdam, in minstens één artikel data heeft gebruikt, die eigenlijk niet op een normale wijze verkregen kunnen zijn. De gegevens zijn te ‘perfect’ en bevatten veel minder ruis dan je normaal verwacht bij het soort experimenten dat Förster uitvoerde.

Begin 2012 publiceerde Förster een artikel in Social Psychological and Personality Science onder de titel Sense Creative! The Impact of Global and Local Vision, Hearing, Touching, Tasting and Smelling on Creative and Analytic Thought. In het artikel beschrijven Förster en zijn co-auteur Markus Denzler een aantal experimenten op basis van een theorie die door Förster is ontwikkeld: GLObal versus LOcal processing Model. Deze theorie, kortweg GLOMO, gaat over het verschil dat zou bestaan tussen het verwerken van waarnemingen van iets in het geheel (global) of meer met een focus op details (local).

Het nieuwe van Försters onderzoek is dat hij het niet alleen beperkt tot visuele waarneming, zoals anderen eerder deden, maar experimenteert met geluid, geur, smaak en aanraking als prikkels. De experimenten komen er meestal op neer dat proefpersonen worden geprimed met ofwel een globale ofwel een lokale prikkel, en dan worden getest met analytische en creatieve testjes (op Wetenschap24 meer uitleg hierover). Uit het abstract van de bewuste studie:

Throughout separate 12 studies, participants were asked to look at, listen to, touch, taste or smell details of objects, or to perceive them as wholes. Global processing increased category breadth and creative relative to analytic performance, whereas for local processing the opposite was true. Results suggest that the way we taste, smell, touch, listen to, or look at events affects complex cognition, reflecting procedural embodiment effects.

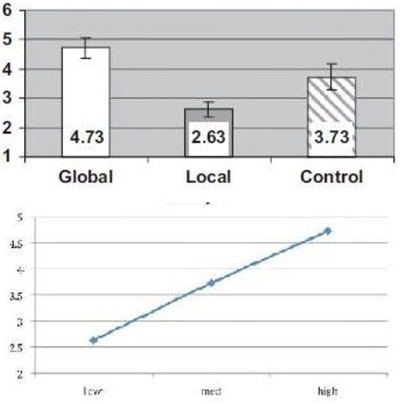

De resultaten leken echter veel te mooi om waar te zijn. Een UvA-collega van Förster, werkzaam op een andere afdeling, viel het op dat het ‘positieve’ effect van de priming met een globale prikkel precies het tegenovergestelde effect had als de priming met een lokale prikkel.

Dat is niet meteen duidelijk als je kijkt naar de grafiekjes van Förster, maar als je de volgorde van de weergave een beetje verandert, zie dat gemiddelden van ‘Global’ en ‘Local’ even ver af liggen van het gemiddelde van de controlegroep (zie afbeelding hiernaast). Dat kan natuurlijk een keer gebeuren, maar het patroon trad op in alle beschreven experimenten.

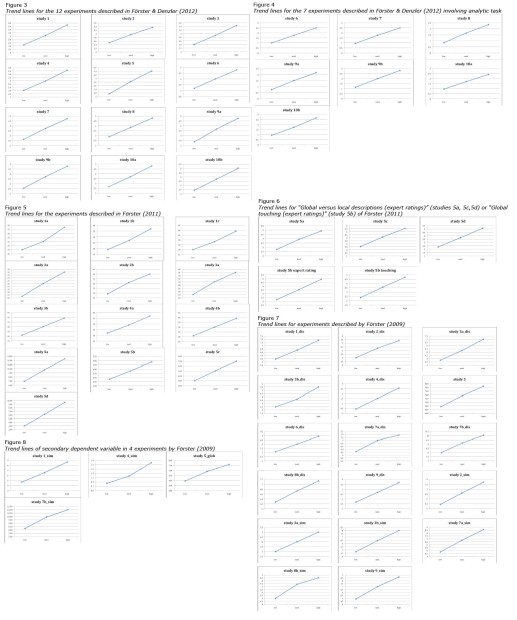

Een tweetal oudere artikelen werd erbij gehaald en daar bleken dezelfde uitgesproken lineaire verbanden op te duiken. In totaal werden in de drie artikelen 42 experimenten gevonden. En die vertonen allemaal hetzelfde beeld, zoals hieronder in een visuele samenvatting gezien kan worden:

Ter vergelijking onderzocht deze medewerker, alleen of met anderen, ook een tiental artikelen van vakgenoten van Förster, waarin een soortgelijke opzet werd gebruikt (dus telkens met drie groepen). Daarin was er geen sprake van een dergelijk sterke lineariteit. De opmerkelijke resultaten van Förster zouden misschien nog wel verklaard kunnen worden door Questionable Research Practices (QRP), zoals het weglaten van uitschieters, het aanvullen van de data met gegevens van extra steekproeven na een eerste evaluatie die net niet lekker uitkwam, of het verwijderen van deelnemers die hun onderzoek niet serieus genoeg hadden ingevuld. Dat laatste zou nog wel mogen, maar dan moet je vooraf precies vastleggen hoe je dat doet en niet achteraf, zoals in het geval Smeesters.

Ook kun je niet meteen uitsluiten dat deze experimenten op een nog onbegrepen lineair verband zijn gestuit. Maar ook als je er van uit gaat dat dat lineair verband er echt is, dan zouden de gegevens daar nog steeds veel te mooi bij passen. Er is veel te weinig spreiding in de gegevens. Bij nadere beschouwing blijkt het ook zeer onwaarschijnlijk dat QRP deze te ‘perfecte’ gegevens zouden kunnen opleveren op basis van een set gegevens die in eerste instantie wel netjes verkregen was. De analyse van de anonieme klager(s) die de basis vormde voor de klacht bij Commissie Wetenschappelijke Integriteit (CWI) van de Universiteit van Amsterdam (UvA) is gelekt naar Retraction Watch.

De klacht werd door de CWI onderzocht, maar die kwam in juli 2013 uiteindelijk niet verder dan de aanbeveling om een ‘letter of concern’ te publiceren omtrent de twijfels over de data (geanonimiseerd rapport, pdf). Förster ontkende dat hij slordig was geweest en zich schuldig had gemaakt aan QRP. De klager vond dat de CWI haar werk onvoldoende had gedaan en ging in beroep bij het LOWI met onder de volgende punten van kritiek: de CWI had archiefonderzoek moeten doen naar de dataverzameling, meer getuigen (onderzoeksassistenten) moeten horen, andere artikelen van Förster en de ruwe databestanden moeten onderzoeken, en ook veel sneller moeten werken.

In het LOWI-rapport(pdf), dat deze week uitkwam (de berichtgeving kwam eind april al op gang na een stuk van Frank van Kolfschooten in NRC), wordt de klager niet op alle punten in het gelijk gesteld. Vooral procedureel valt de CWI niet veel te verwijten. Het is niet zo raar dat die zich beperkt heeft tot de concreet aangedragen problemen. In de zaken van Stapel en Smeesters lag het anders: daar kwamen snel bekentenissen en kregen de CWI’s opdracht van de Colleges van Bestuur om verder onderzoek te doen.

Inhoudelijk geeft het LOWI de klager echter wel gelijk en deelt de mening er eigenlijk geen aanwijzingen zijn gevonden dat QRP tot de onwaarschijnlijke data geleid kunnen hebben en dat het daarom niet bij zo’n ‘letter of concern’ zou kunnen blijven. De statistische experts die vervolgens door het LOWI ingeschakeld werden, kwamen met nog een opmerkelijk gegeven in de data. Als je kijkt naar subgroepen, je splitst de data op naar man/vrouw bijvoorbeeld, dan is er helemaal geen spoor van die lineariteit terug te vinden. De afwijkingen ten opzichte van het lineaire verband bij mannen en vrouwen heffen elkaar precies op als je de data samenvoegt. Dit lijkt helemaal bizar, maar misschien voegt het niet zo veel toe aan het reeds ontstane beeld dat de data sowieso geconstrueerd moeten zijn. En dat door iemand zonder al te veel kennis van statistiek. Förster ontkent intussen dat hij iets verkeerd heeft gedaan en spreekt van een onterechte heksenjacht.

Is het statistisch bewijs voldoende om het oordeel fraude te kunnen vellen? In de analyse van de klager wordt een waarde berekend die zou inhouden dat er maar een kans is van één op 508 triljoen dat de gegevens van een normale steekproef afkomstig zouden kunnen zijn zonder manipulatie. De statisticus Richard Gill (Universiteit Leiden), die zich vaak roert in de commentaren op diverse blogs over deze zaak, geeft echter aan dat je je niet moet blindstaren op dit soort cijfers. Ze hangen af van allerlei aannames rondom de gebruikte modellen. Als handvat om er zinnig mee om te gaan, stelt hij dat je eerst maar eens het aantal nullen moet halveren en als er dan nog steeds een buitensporig aantal nullen staat, halveer je het nog maar eens. In dit geval blijft er dan echter nog steeds een absurd lage kans over. Gill noemt Förster ‘ofwel een oplichter of volkomen incompetent.’

Er zijn ook andere aanwijzingen dat er iets goed is misgegaan. Het LOWI heeft zich alleen gebogen over het artikel dat de aanleiding was tot de klacht. Van de oudere artikelen die ook door de klager zijn geanalyseerd, zijn de gegevens niet eens meer beschikbaar (gecrashte harddisk). Van het artikel in 2012 zijn de originele formulieren vernietigd, hoewel de aangeraden bewaartermijn nog niet was verlopen. En er is onduidelijkheid over wanneer en waar de gegevens precies verzameld zouden zijn. Misschien dat dit soort slordigheden vrij vaak voorkomen (of kwamen) in de sociale psychologie, maar het wordt in dit geval toch wel moeilijk om het niet te zien als een poging om een ernstiger probleem te verhullen.

Samenvattend volgens het LOWI: “is de conclusie […] onontkoombaar dat voor de uitkomsten van dit onderzoek in het artikel onderzoeksgegevens zijn gemanipuleerd of gegevens bewust zijn bijgesteld.” Het oordeelt dat er sprake is geweest van schending van de wetenschappelijke integriteit en adviseert de UvA om het tijdschrift te verzoeken het artikel in te trekken. Op het moment van schrijven van dit stuk was er nog geen officiële mededeling van de UvA, maar de woordvoerder liet al weten dat ze het advies overnemen. Er lijkt vooralsnog geen onderzoek naar andere artikelen van Förster geïnitieerd te worden. [Update 4/10/2014. NRC: ‘UvA gaat toch mogelijke fraude psycholoog onderzoeken‘]

Förster zou eigenlijk volgende maand aan de slag gaan als ‘Humboldt-professor’ in Bochum met een beurs van 5 miljoen euro, dat is voorlopig uitgesteld. In Duitsland is het overigens nog akelig stil rond deze zaak. Merkwaardig, want Förster heeft een grotere status dan Stapel of Smeesters in het vakgebied. Het is opvallend dat deze drie zaken allemaal aan Nederlandse universiteiten naar boven komen. Is het hier erger dan in het buitenland? Waarschijnlijk niet en heeft het er meer mee te maken dat sinds de affaire Stapel de wegen naar CWI’s en LOWI sneller gevonden worden door klokkenluiders en klagers van buitenaf.

Verder lezen:

- Retraction Watch heeft intussen meerdere blogs over de zaak en boeiende discussies daaronder;

- Neuroskeptic op Discover Magazine blogs On the “Suspicion of Scientific Misconduct by Jens Förster”;

- @NotPICNIC houdt een ‘Pearltree‘ bij met relevante websites over deze zaak.