Voor wie de krant de afgelopen dagen mocht hebben gemist – de Tilburgse toponderzoeker Diederik Stapel heeft aan de baas van de Universiteit van Tilburg bekend dat hij onderzoeksgegevens heeft verzonnen. Rector Magnificus Philip Eijlander heeft Stapel daarop direct op non-actief gesteld.

De Universiteit van Tilburg maakte op 7 september bekend dat Stapel op non-actief is gesteld omdat hij ‘een ernstige inbreuk gemaakt [heeft] op de wetenschappelijke integriteit door in zijn publicaties gebruik te maken van gefingeerde data’. Prof. dr. Diederik Stapel is hoogleraar Cognitieve Sociale Psychologie en tevens decaan van Tilburg School of Social and Behavioral Sciences. Rector Eijlander heeft een vertrouwenscommissie ingesteld met de opdracht om volledig in kaart te brengen bij welke publicaties van prof. dr Stapel gefingeerde data zijn gebruikt. Volgens De Telegraaf heeft Stapel al langere tijd onderzoeksgegevens verzonnen.

Uit media-artikelen van gisteren (o.a. een voorpagina-artikel in NRC Handelsblad) wordt duidelijk wat er gebeurd is. Wikipedia citeert Omroep Brabant:

‘Eind augustus 2011 meldden enkele jonge medewerkers uit Stapels onderzoekgroep zich bij de rector van de Universiteit van Tilburg, Philip Eijlander met het vermoeden van frauduleuze handelingen bij het onderzoek. Ongeveer een week later gaf Stapel toe dat er in sommige publicaties sprake was van gefingeerde data. Vrijwel onmiddellijk hierop werd Stapel op non-actief gesteld. Een commissie onder leiding van de psycholoog Willem Levelt werd verzocht te onderzoeken welke publicaties er precies gebaseerd waren op gefingeerde data’.

Diederik Stapel is volgens NRC-redacteur Bart Funnekotter een zeer succesvol wetenschapper. Funekotter op de webpagina van de NRC:

‘Hij promoveerde cum laude en kreeg diverse beurzen van NWO en de KNAW. Hij doet onderzoek naar hoe bij mensen hun zelfbeeld en het beeld van anderen ontstaat. Eerder dit jaar kwam hij overal in het nieuws, ook bij NRC, met zijn onderzoek waaruit bleek dat mensen die in een rommelige omgeving leven, eerder een hekel hebben aan buitenlanders. Dat onderzoek is gepubliceerd in Science, de absolute top van de wetenschappelijke tijdschriften’.

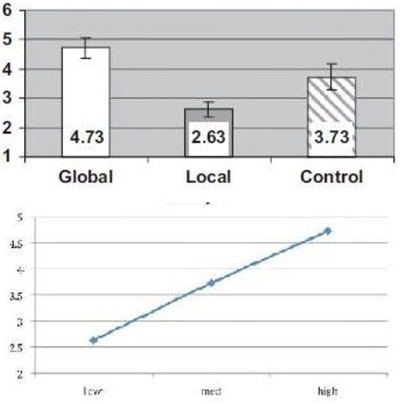

Een paar dagen geleden kwam Stapel nog uitgebreid in het nieuws met zijn onderzoek waaruit zou blijken dat ‘vleeseters egoïstischer en minder sociaal zijn dan mensen die geen vlees eten’. Ook dit onderzoek is vermoedelijk geheel gebaseerd op verzonnen gegevens, zo meldt medeonderzoeker prof. Roos Vonk.

Juist vanwege het grote zichtbaarheid van Stapel (hij was regelmatig te zien op tv) maakt prof. Roos Vonk zich grote zorgen over de reputatieschade voor de wetenschap. In NRC Handelsblad zegt ze: ‘het is denkbaar dat dat deze omvangrijke misstap van één enkele collega effecten heeft op de reputatie van ons gehele vakgebied’. Ook Robbert Dijkgraaf, president van de Koninklijke Nederlandse Akademie van Wetenschappen, maakt zich hierover grote zorgen, zegt hij in het weekblad Elsevier. Op haar website toont Vonk zich verbijsterd:

‘Op 25 augustus j.l. presenteerde ik, samen met collega’s Diederik Stapel en Marcel Zeelenberg, een onderzoek naar de psychologie van vlees. Dit onderzoek hadden we gezamenlijk bedacht en het was uitgevoerd door een assistent van Diederik. Dacht ik. … Vandaag (7 september) hoorde ik dat collega Stapel op grote schaal fraude heeft gepleegd. … Ik moet aannemen dat ook de ‘vlees-data’ berusten op fraude. Bij het bespreken van de resultaten vond ik het wel vreemd dat Diederik de naam van de assistent niet noemde, maar de gedachte aan fraude is geen moment in me opgekomen. Diederik Stapel was een van de beste sociaal-psychologen van Europa. Hij had een vlekkeloze reputatie, … Dat uitgerekend hij dit gedaan heeft maakt het extra schokkend en laat zien hoezeer ook wij als psychologen ons volstrekt kunnen vergissen in mensen’.

Volgens de website Universonline van de Universiteit Tilburg begrijpt Stapel dat wat hij heeft gedaan niet door de beugel kan:

‘Of de universiteit nog actie onderneemt om de schade voor Stapel te beperken, is onduidelijk. Eijlander geeft aan dat hij het volstrekt verwerpelijk vindt wat Stapel heeft gedaan. “Diederik begrijpt dit ook.” Binnen de wetenschap zal Stapel moeilijk ergens anders aan de slag komen, maar hij zal weer de kracht vinden om verder te gaan, aldus de rector. De drie klokkenluiders zijn sterke mensen aldus Eijlander. “Ik vind het top dat ze dit gedaan hebben, het is het enige juiste geweest. De wetenschap heeft zichzelf gezuiverd”.

Hier vind je een overzicht van publicaties van Diederik Stapel (bron: wikipedia). Hier vind je zijn curriculum vitae (googledocs document, via Wikipedia).

Voorpagina: een deel van de voorpagina van NRC Handelsblad van 8 september 2011